Die Crawlability einer Website und das Crawlbudget verstehen

Crawlability ist ein grundlegender Aspekt des Technical SEO und bezieht sich auf die Fähigkeit von Suchmaschinen, die Seiten einer Website zu durchsuchen und ihre Inhalte zu verstehen. Das Crawlbudget umfasst die Anzahl der Seiten, die ein Suchmaschinen-Crawler innerhalb eines bestimmten Zeitraums auf einer Website durchsucht. Eine gute Crawlability ist entscheidend dafür, dass Suchmaschinen alle wichtigen Seiten einer Website finden und indexieren können – und damit das zur Verfügung stehende Crawlbudget bestmöglich ausgenutzt wird.

In diesem Artikel erkläre ich dir, was Crawlability und Crawlbudget genau für deine Website bedeuten, warum sie wichtig sind und welche Faktoren sie beeinflussen.

Definition von Crawlability

Crawlability beschreibt die Fähigkeit von Suchmaschinen-Crawlern (auch Bots oder Spider genannt), auf die Inhalte einer Website zuzugreifen, sie zu durchforsten und die darin enthaltenen Informationen zu verarbeiten. Ein Suchmaschinen-Crawler ist ein automatisiertes Programm, das das Internet durchsucht, um Webseiten zu entdecken und zu indexieren. Zu den bekanntesten Crawlern gehören Googlebot, Bingbot und Yahoo Slurp.

Warum ist Crawlability wichtig?

Nur Seiten, die von Suchmaschinen gecrawlt werden können, werden auch indexiert und können somit in den Suchergebnissen erscheinen. Wenn wichtige Seiten nicht gecrawlt werden können, verlieren sie die Möglichkeit, in den Suchergebnissen gut zu ranken, was zu einem Verlust von Sichtbarkeit und Traffic führt.

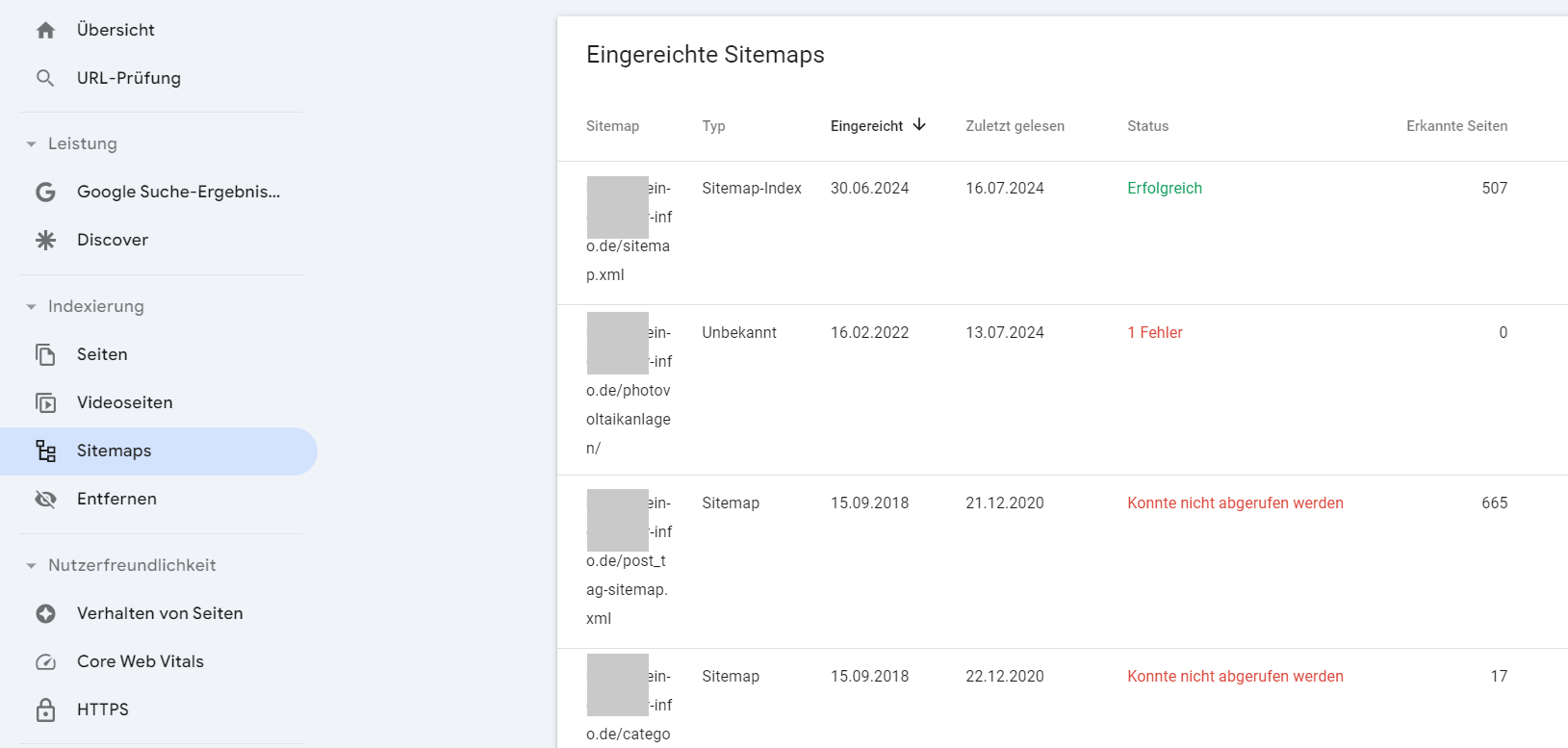

In diesem Beispiel hat einer Kunden selbsg Sitemaps bei der Google Search Console hochgeladen und einige Fehler gemacht. Erst nach Jahren nach einem SEO-Audit durch uns wurde die Sitemap in der richtigen Art und Weise hinzugefügt.

Faktoren, die die Crawlability beeinflussen

- Eine XML-Sitemap ist eine Datei, die alle wichtigen Seiten einer Website auflistet und Suchmaschinen dabei hilft, diese Seiten zu finden. Sie ist besonders nützlich für große Websites oder solche mit komplexen Strukturen.

- Die robots.txt-Datei gibt Suchmaschinen Anweisungen, welche Bereiche der Website sie crawlen dürfen und welche nicht. Eine falsch konfigurierte robots.txt-Datei kann versehentlich wichtige Seiten vom Crawling ausschließen.

- Eine klare und logische URL-Struktur erleichtert es Suchmaschinen, die Beziehungen zwischen verschiedenen Seiten zu verstehen. Kurze, sprechende URLs sind hier von Vorteil.

- Eine gut durchdachte interne Verlinkung hilft Suchmaschinen-Crawlern, alle Seiten einer Website zu entdecken und deren Bedeutung zu verstehen. Seiten, die tief in der Website-Struktur verborgen sind und nur wenige interne Links haben, können schwer zu finden sein.

- Langsame Server-Antwortzeiten können dazu führen, dass Suchmaschinen-Crawler nicht alle Seiten einer Website durchsuchen können. Eine schnelle und zuverlässige Serverleistung ist daher wichtig für eine gute Crawlability.

- Fehlerseiten (z.B. 404-Fehler) und schlecht konfigurierte Weiterleitungen können den Crawl-Prozess behindern. Es ist wichtig, regelmäßige Überprüfungen durchzuführen und sicherzustellen, dass alle Links auf der Website funktionieren.

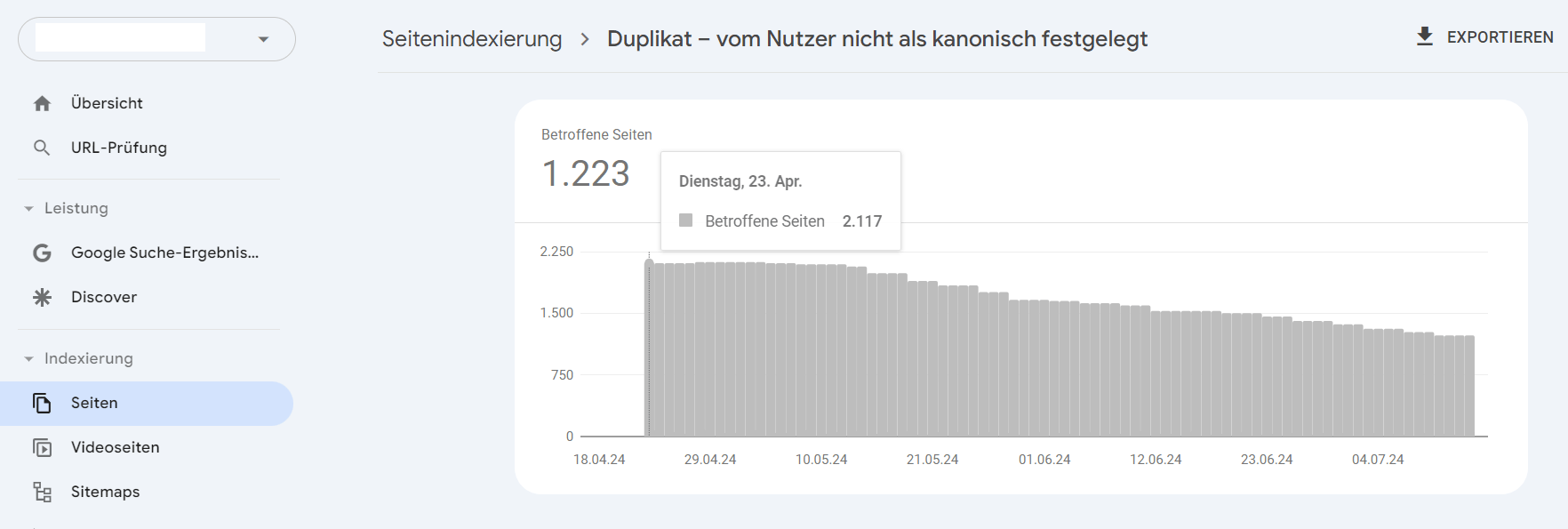

- Doppelter Content (Duplicate Content) kann Suchmaschinen verwirren und dazu führen, dass sie nicht wissen, welche Version einer Seite sie indexieren sollen. Die Verwendung von Canonical Tags kann hier helfen, das Problem zu lösen.

Über Duplicate Content ohne Canonical Tags weist auch die Search Console hin. Hier baut der Kunde bereits die Seiten Stück für Stück ab nach Aufdecken durch ein SEO-Audit über uns.

Das Crawlbudget und seine Bedeutung für die Crawlability

Das Crawlbudget ist ein wichtiger Begriff im Bereich des Technical SEO, der sich auf die Anzahl der Seiten bezieht, die ein Suchmaschinen-Crawler innerhalb eines bestimmten Zeitraums auf einer Website durchsucht. Es steht in direktem Zusammenhang mit der Crawlability einer Website, da ein effizientes Management des Crawlbudgets sicherstellt, dass Suchmaschinen-Crawler die wichtigsten Seiten einer Website finden und indexieren können.

Das Crawlbudget setzt sich aus zwei Hauptkomponenten zusammen:

- Crawl Rate Limit (Crawlerate-Limit): Dies ist die Anzahl der Anfragen, die ein Suchmaschinen-Crawler an eine Website senden kann, ohne die Serverleistung zu beeinträchtigen. Google passt diese Rate automatisch an, um sicherzustellen, dass der Server nicht überlastet wird.

- Crawl Demand (Crawl-Nachfrage): Dies hängt von der Popularität und Aktualität der Seiten ab. Häufig aktualisierte oder besonders relevante Seiten haben eine höhere Crawl-Nachfrage und werden häufiger gecrawlt.

Warum ist das Crawlbudget wichtig?

Ein effizientes Management des Crawlbudgets ist entscheidend, weil Suchmaschinen eine begrenzte Anzahl von Seiten pro Website innerhalb eines bestimmten Zeitraums crawlen. Besonders für große Websites oder Websites mit häufigen Aktualisierungen ist es wichtig, dass die relevantesten Seiten priorisiert werden. Ein ineffizientes Crawlbudget kann dazu führen, dass wichtige Seiten nicht gecrawlt oder indexiert werden, was negative Auswirkungen auf die Sichtbarkeit in den Suchmaschinen hat.

Das obere Projekt weist bereits über 1.200 Duplicate Seiten auf, die das Crawlbudget unnütz beanspruchen. Schlimmer noch ist der Einfluss der 404-Seiten, die die Search Console erfasst. Bei dieser hohen Anzahl wird schnell deutlich, dass viele irrelevante Seiten gecrawlt werden und so das Crawlbudget sehr ineffizient genutz werden. Siehe hier:

Zusammenhang zwischen Crawlbudget und Crawlability

Es gibt zwei ganz praktische Ansätze, um sowohl die Crawlability als auch das Crawlbudget zu verbessern:

1. Optimierung der Crawlability zur Maximierung des Crawlbudgets durch Vermeidung von Duplicate Content und Verbesserung der internen Verlinkung.

Doppelter Content verschwendet das Crawlbudget, da Crawler dieselben Inhalte mehrfach durchforsten. Durch den Einsatz von Canonical Tags und die Vermeidung redundanter Seiten kann das Crawlbudget effizienter genutzt werden. Eine gut strukturierte interne Verlinkung hilft Suchmaschinen-Crawlern, die wichtigsten Seiten schnell zu finden und zu durchsuchen. Dies stellt sicher, dass das Crawlbudget nicht für unwichtige oder schwer zugängliche Seiten verschwendet wird.

Technische Fehler wie 404-Seiten oder langsame Ladezeiten können das Crawling behindern und das Crawlbudget ineffizient nutzen. Regelmäßige Überprüfungen und Optimierungen der Website-Performance sind daher für deinen Erfolg entscheidend.

2. Effizientes Management des Crawlbudgets zur Verbesserung der Crawlability

XML-Sitemaps helfen Suchmaschinen, die wichtigsten Seiten einer Website zu finden und zu priorisieren. Dies trägt dazu bei, dass das Crawlbudget effizient genutzt wird und die wichtigsten Inhalte gecrawlt werden. Durch die richtige Konfiguration der robots.txt-Datei können unnötige Seiten vom Crawling ausgeschlossen werden, sodass das Crawlbudget auf die relevanten Seiten konzentriert wird. Auch verbessern regelmäßige Aktualisierungen und das Zusammenführen ähnlicher Seiten die Relevanz und Aktualität der Inhalte, was wiederum die Crawl-Nachfrage erhöht und das Crawlbudget effizienter nutzt.

Führe regelmäßige Überprüfungen durch, um Crawling-Hindernisse wie 404-Fehler, langsame Ladezeiten und andere technische Probleme zu identifizieren und zu beheben.

Serverantwortzeiten, Website-Performance und ihr Zusammenhang mit dem Crawlbudget

Die Serverantwortzeiten und die Performance einer Website haben einen direkten Einfluss auf das Crawlbudget. Eine langsame Website kann das Crawlbudget negativ beeinflussen und somit die Effizienz der Indexierung durch Suchmaschinen verringern.

Die Serverantwortzeit ist die Zeit, die ein Webserver benötigt, um auf eine Anfrage eines Benutzers oder Suchmaschinen-Crawlers zu reagieren. Sie ist ein wichtiger Indikator für die Performance einer Website und kann die Crawlrate beeinflussen.

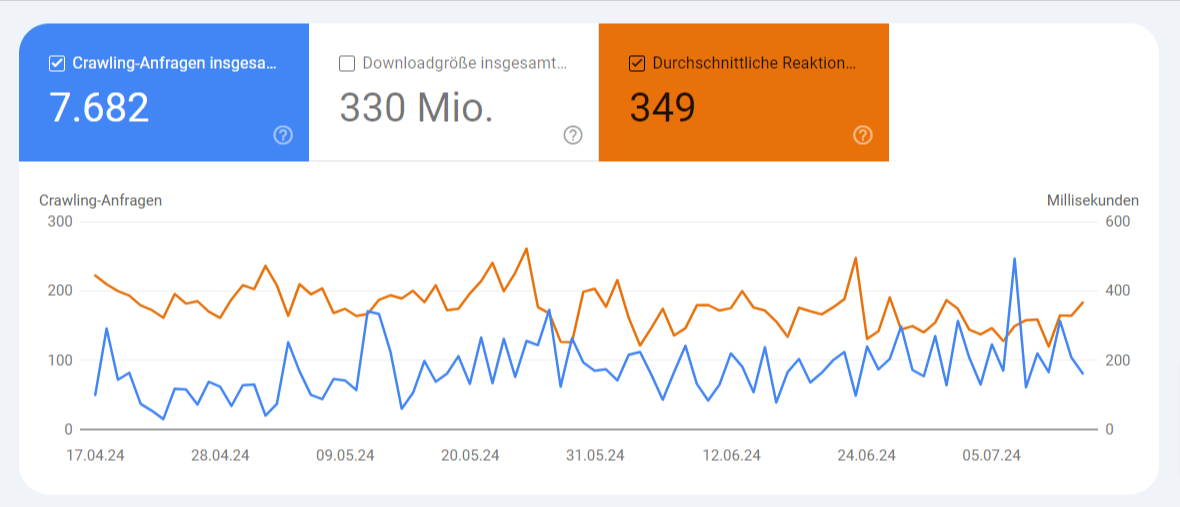

Du findest Angaben zu deiner durchschnittlichen Serverantwortzeit in der Google Search Console unter Einstellungen => Crawlingstatistiken. Hier ist ein Beispiel mit einer sehr guten durchschnittlichen Serverantwortzeit:

Welchen Einfluss haben Serverantwortzeiten auf das Crawlbudget?

- Wenn eine Website langsame Serverantwortzeiten hat, benötigen Suchmaschinen-Crawler mehr Zeit, um jede Seite zu durchsuchen. Dies kann dazu führen, dass weniger Seiten innerhalb eines bestimmten Zeitraums gecrawlt werden, denn dein Crawlbudget ist begrenzt.

- Google passet die Crawlrate dynamisch an die Serverantwortzeiten an. Wenn die Antworten des Servers langsam sind, reduziert Google die Anzahl der Anfragen, um die Serverleistung nicht zu beeinträchtigen. Dies bedeutet, dass weniger Seiten gecrawlt werden, was das Crawlbudget ineffizient macht.

Priorisierung von schnellen Websites: Suchmaschinen bevorzugen Websites mit schnellen Ladezeiten und schnellen Serverantwortzeiten. Eine langsame Website kann daher eine niedrigere Priorität beim Crawling erhalten, was sich negativ auf das Crawlbudget auswirkt. - Die allgemeine Performance einer Website umfasst mehrere Aspekte, darunter Ladegeschwindigkeit, Time to First Byte (TTFB), und allgemeine Benutzerfreundlichkeit. Eine gut optimierte Website bietet nicht nur eine bessere Benutzererfahrung, sondern auch effizienteres Crawling.

Was kannst du also tun? Klar, die Ladezeiten verbessern und die Serverlast reduzieren! Websites, die schnell laden, ermöglichen es Suchmaschinen-Crawlern, mehr Seiten in kürzerer Zeit zu durchsuchen. Dies maximiert das Crawlbudget und stellt sicher, dass wichtige Seiten gecrawlt und indexiert werden. Eine gut optimierte Website reduziert die Serverlast und sorgt dafür, dass Suchmaschinen-Crawler effizient arbeiten können, ohne die Serverperformance zu beeinträchtigen. Dies führt zu einer besseren Nutzung des Crawlbudgets.

Eine schnelle und reibungslose Benutzererfahrung erhöht die Verweildauer der Benutzer und senkt die Absprungrate. Suchmaschinen berücksichtigen diese Faktoren bei der Bewertung der Relevanz und Qualität einer Website, was sich positiv auf das Ranking auswirken kann.

Google selbst meint in seinem Hilfeartikel zum Crawl-Budget: Wenn die Website eine Zeit lang sehr schnell reagiert, wird die Begrenzung erhöht, sodass mehr Verbindungen für das Crawling verwendet werden können. Falls die Website langsamer wird oder mit Serverfehlern antwortet, verringert sich die Begrenzung und der Googlebot crawlt weniger.

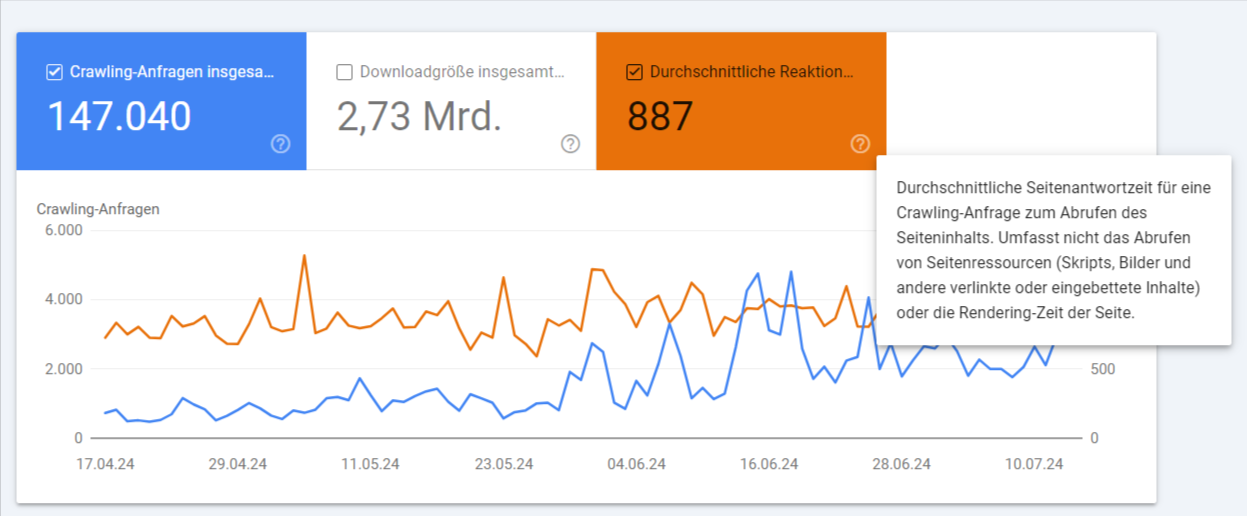

Hier ist noch ein anderer Screenshot aus einem anderen Projekt. Der Wert der Serverantwortzeit beträgt über 800. Das ist fast schon unglückliche Normalität, so unsere Beobachtung. Viele Projekte schaffen kaum durchschnittliche Werte unter 500. Unser persönlich erreichter Tiefstwert war mit TutKit.com 249, wobei wir noch ein Shopify-Projekt kennen, das diesen Wert nach unten toppen konnte. Respekt!

Stellst du bei dir einen relativ hohen Wert bei den Serverantwortzeiten fest, kannst du einige praktische Maßnahmen zur Optimierung der Serverantwortzeiten und der Website-Performance vornehmen:

- Ein CDN verteilt die Last der Inhaltsbereitstellung auf mehrere Server weltweit, was die Ladezeiten reduziert und die Serverantwortzeiten verbessert. Das ist besonders bei mehrsprachigen Websites mit internationalen Besuchern sinnvoll.

- Komprimiere und optimiere deine Bilder und andere Medieninhalte, um die Ladezeiten zu verkürzen. Nutze vor allem moderne Bildformate für das Web wie AVIF oder WebP.

- Implementiere Browser-Caching und serverseitiges Caching, um wiederholte Anfragen zu reduzieren und die Ladegeschwindigkeit zu erhöhen.

- Reduziere die Anzahl der HTTP-Anfragen, indem Sie CSS- und JavaScript-Dateien zusammenführen und unnötige Plugins entfernen.

- Minimieren Sie die Verwendung von Drittanbieter-Skripten, die die Ladezeit der Website negativ beeinflussen können.

- Nutze Tools wie Google PageSpeed Insights, Lighthouse und WebPageTest, um die Performance deiner Website regelmäßig zu überwachen und Optimierungspotenziale zu identifizieren.

- Stelle sicher, dass dein Server über ausreichende Ressourcen verfügt und regelmäßig gewartet wird. Nutze moderne Webserver-Technologien wie NGINX oder HTTP/2.

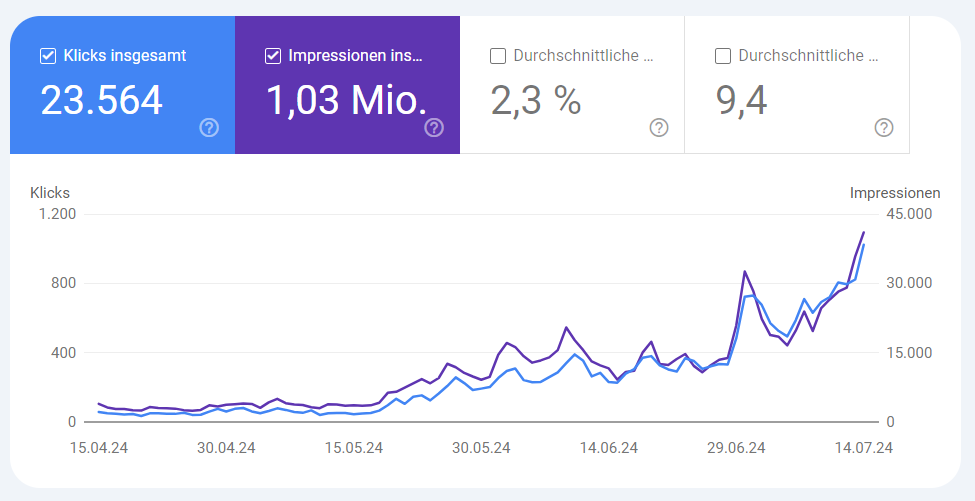

Gerade der letzte Punkt hat in einem unserer Kundenprojekte den Flaschenhals gelöst. Im Juni wurden in diesem Projekt die Probleme rund um Core Web Vitals gelöst und am Anfang Juli erfolgte der Serverwechsel mit einem ordentlichen Upgrade auf ein modernes Setup und guter Leistung. Auf einmal ging es schlagartig nach oben.

Trotz aller Bemühungen können manche Seiten Schwierigkeiten bei der Crawlability haben. Hier sind einige häufige Probleme und mögliche Lösungsansätze:

Fehlerhafte Robots.txt-Datei

Problem: Eine falsch konfigurierte robots.txt-Datei kann Suchmaschinen-Crawler daran hindern, wichtige Seiten zu durchforsten.

Lösung: Überprüfe die robots.txt-Datei, um sicherzustellen, dass keine relevanten Seiten versehentlich ausgeschlossen werden. Verwenden Sie das Robots.txt-Tester-Tool von Google.

Fehlende oder unvollständige XML-Sitemaps

Problem: Ohne eine oder mit einer fehlerhaften XML-Sitemap kann es für Suchmaschinen schwierig sein, alle Seiten einer Website zu entdecken. Siehe Beispielscreenshot oben.

Lösung: Erstelle und übermittele eine vollständige XML-Sitemap an die Google Search Console. Und achte auf die Verifzierung der Korrektheit. Aktualisiere diese regelmäßig.

Tief verschachtelte Seiten

Problem: Seiten, die viele Klicks von der Startseite entfernt sind, werden möglicherweise nicht gecrawlt. Siehe auch Screenshot von oben aus Audisto. Die meisten Seiten lagen auf der Ebene 6 bis 8.

Lösung: Optimieren Sie die interne Verlinkung, um sicherzustellen, dass alle wichtigen Seiten in wenigen Klicks erreichbar sind.

Duplicate Content

Problem: Doppelte Inhalte können dazu führen, dass Suchmaschinen Schwierigkeiten haben, die relevanteste Version einer Seite zu identifizieren.

Lösung: Verwenden Sie Canonical Tags, um die Hauptversion einer Seite zu kennzeichnen, und vermeiden Sie doppelten Content.

Fehlende oder fehlerhafte Weiterleitungen

Problem: Broken Links und fehlgeleitete Weiterleitungen können den Crawl-Prozess behindern.

Lösung: Nutzen Sie 301-Weiterleitungen für dauerhaft verschobene Inhalte und vermeiden Sie 302-Weiterleitungen für dauerhafte Änderungen. Überprüfen Sie regelmäßig auf Broken Links.

Übermäßige Parameter in URLs

Problem: URLs mit vielen Parametern können für Suchmaschinen schwer zu durchforsten sein. Das ist gerade bei Shopseiten oft der Fall, die beispielsweise Varianten (in Gewicht, Größe, Farbe etc. über Parameter ausgeben) für Produkte haben

Lösung: Verwende URL-Parameter nur, wenn sie unbedingt erforderlich sind, und strukturiere URLs möglichst einfach und lesbar.

Serverprobleme

Problem: Serverfehler wie 5xx-Fehler können dazu führen, dass Suchmaschinen-Crawler die Seiten nicht erreichen können.

Lösung: Überwache die Serverleistung und behebe auftretende Fehler umgehend. Stelle sicher, dass dein Server eine hohe Verfügbarkeit hat.

Fazit zur Crawlability und zum Crawl-Budget

Das Crawlbudget ist ein Faktor, den du kennen solltest für die effiziente Indexierung und Sichtbarkeit einer Website in den Suchmaschinen. Durch die Optimierung der Crawlability und das effiziente Management des Crawlbudgets kannst du als Website-Betreiber sicherstellen, dass deine wichtigsten Seiten regelmäßig gecrawlt und indexiert werden. Dies führt zu einer besseren Sichtbarkeit in den Suchmaschinen und letztlich zu mehr organischem Traffic und einer besseren Benutzererfahrung.

Die Serverantwortzeiten und die Performance einer Website spielen eine entscheidende Rolle für die effiziente Nutzung des Crawlbudgets. Langsame Serverantwortzeiten und eine schlecht optimierte Website können das Crawlbudget ineffizient machen und die Anzahl der gecrawlten Seiten reduzieren. Durch die Optimierung der Ladegeschwindigkeit, die Implementierung von Caching-Strategien und die Reduzierung von HTTP-Anfragen kann die Performance der Website verbessert werden. Dies führt zu schnelleren Serverantwortzeiten, einer effizienteren Nutzung des Crawlbudgets und letztendlich zu einer besseren Sichtbarkeit und Benutzererfahrung.

Eine gute Crawlability ist die Grundlage für eine erfolgreiche Indexierung und Sichtbarkeit in den Suchmaschinen. Durch die Umsetzung der beschriebenen Maßnahmen kann sichergestellt werden, dass Suchmaschinen-Crawler alle wichtigen Seiten einer Website finden und indexieren können. Dies verbessert nicht nur das Ranking in den Suchergebnissen, sondern auch die Benutzererfahrung und die allgemeine Leistung der Website.

Um mit den Worten von Google selbst zu schließen: Eine schnellere Website ist nutzerfreundlicher und ermöglicht gleichzeitig eine höhere Crawling-Frequenz. Für den Googlebot ist eine schnelle Website ein Zeichen für gut funktionierende Server. So kann er mehr Inhalte über die gleiche Anzahl von Verbindungen abrufen.

Hast du sehr viele Seiten auf deiner Website aber zu viele sind nicht gecrawlt oder indexiert, melde dich bei uns. Wir können dir helfen!